Cren

Forumer storico

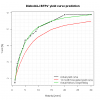

Per quei pochi che si stessero chiedendo «Ma Diebold e Li dicono che il loro modello ha massima efficacia previsionale a 12 mesi di distanza, ad 1 mese fa schifo! Quindi?», mostro la previsione a 12 mesi.Con un AR(1) per ciascun parametro, possiamo fare una previsione per il prossimo mese

Non è difficile capire da dove salta fuori: verosimilmente il modello estrae un comportamento mean reverting da beta_0 e quindi giudica in questo momento la curva italiana 'alta', ovvero ritiene che debba tornare a più miti valori con i BTP che salgono di prezzo.

Fategli capire che abbiamo avuto Berlusconi e qualche altro problemino come l'euro, la Germania e un grosso rischio default nel mezzo

Oppure il modello è più furbo di tutti e sa che Monti ci salverà? Ne dubito fortemente

Concludo per chi se lo stesse chiedendo: sì, sono andato a verificare le previsioni del modello qualche mese prima dell'attacco speculativo che ci ha investiti nell'ultimo trimestre del 2011; la risposta è ovviamente scontata: lungi dal modello essere in grado di anticipare quel movimento devastante sulla curva dei BTP.

D'altronde per giustificare questo scivolone l'econometrista devoto scomoderebbe quasi sicuramente almeno un paio di simpatici break strutturali che invalidano le stime fatte.

Io, che econometrista non sono, molto più prosaicamente mi permetto di suggerire che quando un emittente subisce dei downgrade sarebbe il caso di considerare la sua curva da zero ed evitare raffronti col passato, perchè è verosimile che questo non abbia più alcuna valenza.

Questo non perchè io attribuisca proprietà divinatorie ai rating, ma semplicemente perchè la stragrande maggioranza dei modelli di gestione del rischio di portafogli obbligazionari sono parametrati alle migrazioni da una classe di rating all'altra, e quindi vi conviene adeguarvi ai flussi dei fondi obbligazionari e delle gestioni patrimoniali.

In soldoni: fate il giochino Diebold-Li usando campioni omogenei per classe di rating dell'emittente, non pensate nemmeno di stimare i parametri su un campione che ha anche solo una variazione di rating nel mezzo!

Allegati

Ultima modifica: